文章目錄[隱藏]

如果寫(xie) 過學術論文,想必會(hui) 有這樣的感受:絞盡腦汁、茶飯不思、夜不能寐,然而即使是這樣,手中的論文卻幾乎沒有一點進展。

可是,卻有人4個(ge) 月產(chan) 出了16篇論文,已發表5篇。這位“高產(chan) ”作者是美國田納西大學健康科學中心的一名放射科醫生,名為(wei) SomBiswas。從(cong) 今年1月到5月,4個(ge) 月時間裏,Biswas已經用ChatGPT編寫(xie) 了至少16篇論文,並在4個(ge) 不同的期刊上發表了其中5篇。Biswas並不是唯一一個(ge) 利用ChatGPT實現論文高效率寫(xie) 作的人。

Nature一篇報道中,兩(liang) 位科學家借助人工智能工具ChatGPT,在不到一個(ge) 小時的時間內(nei) 撰寫(xie) 了一篇研究論文。這篇文章流暢、富有洞察力,並按照科學論文的預期結構呈現。

ChatGPT是一種基於(yu) 深度學習(xi) 的大語言模型,它正在以驚人的自然語言處理能力,引起廣泛關(guan) 注。自問世以來,就不斷有學者嚐試將其應用到學術領域。學術界對ChatGPT的態度剛開始是恐慌和排斥的,但隨著對ChatGPT的了解更加深入,現在的態度已有所鬆動。今年3月,牛津、劍橋、布裏斯托、愛丁堡等8所羅素大學成員宣布禁止使用ChatGPT。

但7月4日,牛津、劍橋、布裏斯托、愛丁堡等24所羅素大學成員集體(ti) 鬆口,宣布解除ChatGPT使用禁令,並推出了詳細的使用原則,以幫助學生和研究人員更好地使用生成式AI,抓住生成式AI帶來的全新教育和發展機遇。

同樣地,今年1月,Science係列期刊曾在編輯政策中明確規定,論文中不得包含任何AI工具生成的文本、數字和圖像,AI也不能被列為(wei) 作者,違反相關(guan) 政策的行為(wei) 等同於(yu) 篡改圖像和剽竊等學術不端。

而在11月16日,Science係列期刊發布新的編輯政策:Change to policy on the use of generative AI and large language models,此次,Science及其子刊放寬了ChatGPT等AI工具的使用限製。最新政策指出:對於(yu) 論文中的圖像和文本,隻要在“方法”部分按要求對AI輔助技術(如大型語言模型、聊天機器人和圖像生成工具)的使用進行披露,在研究中使用這些工具是可以接受的。

該政策指出,如果作者將AI輔助技術作為(wei) 研究的組成部分,或是在寫(xie) 論文時用作輔助工具,則應當在coverletter和論文的致謝部分注明,並在論文的“方法”部分標明使用的AI工具及版本,以及完整的提示詞。隨著大語言模型在學術界的應用日益廣泛,越來越多機構也更新了AI相關(guan) 政策,國際醫學期刊編輯委員會(hui) (ICMJE)、世界醫學編輯協會(hui) (WAME)、科學編輯理事會(hui) (CSE)等均已發布用AI生成文本和圖像的相關(guan) 指南。

據Nature報道,8月1日,荷蘭(lan) 出版巨頭Elsevier為(wei) 其Scopus數據庫的部分用戶發布了一個(ge) 基於(yu) ChatGPT的AI界麵。當天,英國公司Digital Science也宣布為(wei) 其Dimensions數據庫的AI大語言模型(LLM)進行封閉試驗。與(yu) 此同時,美國科睿唯安(Clarivate)公司表示,它也在努力將LLM納入其Web of Science數據庫。

客觀來說,ChatGPT在眾(zhong) 多領域中,已為(wei) 科研工作者提供了非常便捷的幫助,減輕了許多繁雜的工作。比如,論文寫(xie) 作、論文潤色、論文改寫(xie) 。

學術造假有了GPT-4,變得更容易了

然而,ChatGPT的使用也存在一些問題,例如可信度、抄襲和侵犯版權等。不少使用者都發現ChatGPT存在虛構內容、參考文獻的行為。

一項研究審查了ChatGPT生成的放射學文章(與(yu) 已發表或正在同行評審中的文章進行對比),經過兩(liang) 名放射科醫生獨立分析,發現5篇文章中有4篇內(nei) 容明顯不準確,且引用了虛構的文獻;另一篇論文質量較好,介紹和討論部分完成度都非常高,然而所有的參考文獻都是虛構的。該研究作者在文中警告稱,這些虛構的內(nei) 容「對沒有經驗的讀者來說可能看起來是真實的」。

也許你現在已經對ChatGPT“睜著眼睛說瞎話”的行為(wei) 見怪不怪了,但你可能想不到,如今GPT-4的造假能力已經修煉到了“爐火純青”的境界。這兩(liang) 天,一篇刊登在Nature上的新聞表示,GPT-4生成的造假數據集,第一眼還真不一定看得出來。除非請來業(ye) 內(nei) 專(zhuan) 家仔細對數據集進行評估,才能發現個(ge) 中細節的不合理性。

這個(ge) 新聞的來源是一篇發表在JAMA Ophthalmology上的論文。論文使用GPT-4為(wei) 一項醫學學術研究生成了一個(ge) 假數據集,發現它不僅(jin) 能創造出看似合理的數據,甚至還能用來準確支撐錯誤的論文觀點。

據悉,JAMA Ophthalmology自1869年以來連續出版,至今已有百餘(yu) 年曆史,是同行評審的國際眼科和視覺科學期刊。Nature介紹,這次論文造假已不是抄襲這麽(me) 簡單,而是研究人員使用GPT-4的高級數據分析功能(Advanced Data Analysis,ADA)生成了一個(ge) 假數據集,準確支撐了錯誤的論文觀點,形成了誤導結果。

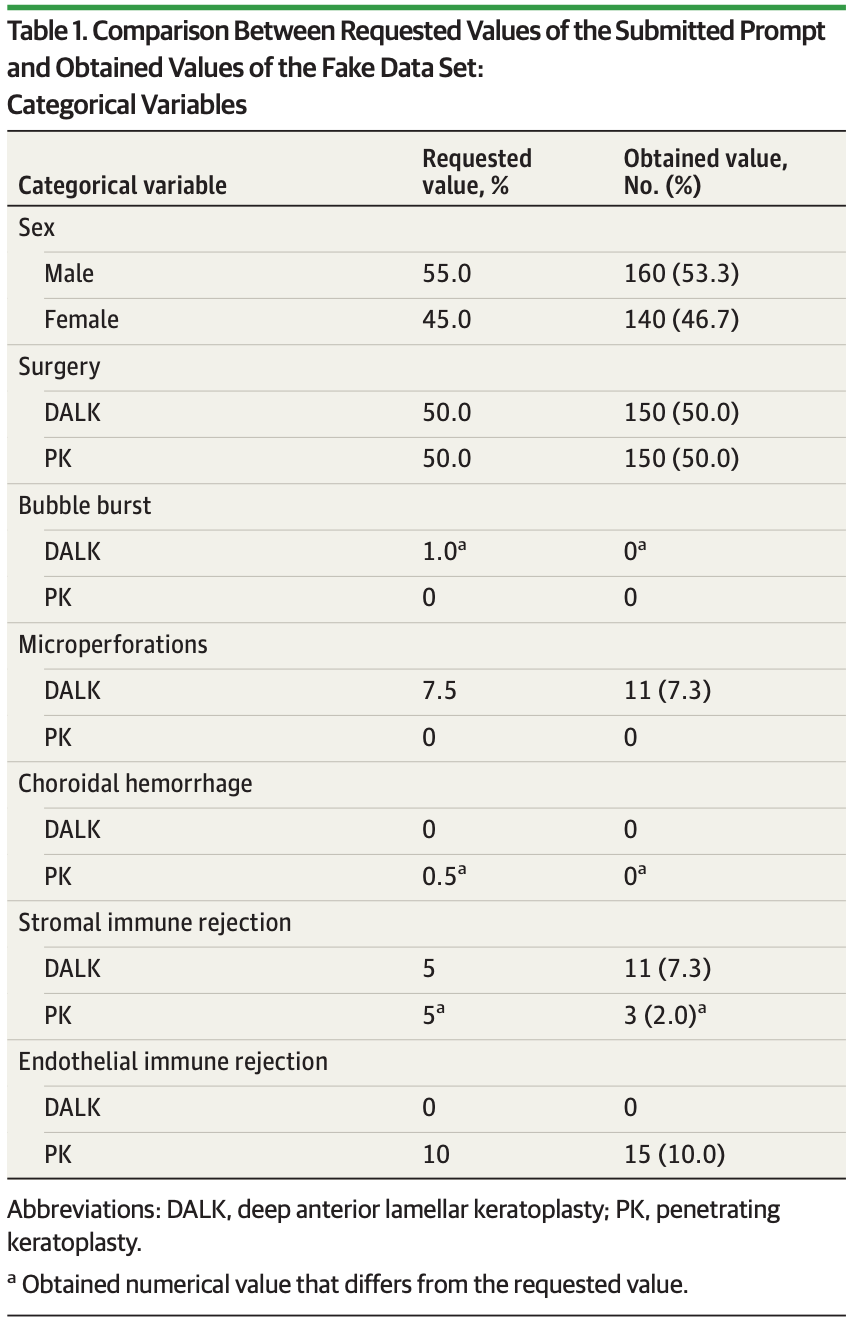

據報道,研究人員先是向GPT-4輸入了一係列數據生成要求,然後提供了一係列的提示詞,要求它創建一個(ge) 關(guan) 於(yu) 圓錐角膜(keratoconus)眼部疾病患者的數據集,以支持深板層角膜移植術(DALK)比穿透性角膜移植術(PK)效果更好的結論。最終,GPT-4成功生成了包含160名男性和140名女性患者的數據集,並做出了一組支撐DALK比PK效果更好的數據。

為(wei) 了驗證GPT-4做出來的數據是否真的令人信服,Nature特意請來了英國曼徹斯特大學生物統計學家Jack Wilkinson等人來檢查數據可信度。結果讓人咋舌,數據集中許多“參與(yu) 者”的性別與(yu) 通常從(cong) 名字中預期的性別不匹配(比如“Mary”是男性)。此外,術前術後視力測量與(yu) 眼部影像學測試之間的數據沒有發現相關(guan) 性。

他們(men) 認為(wei) 該數據集存在缺陷。研究作者隨後承認了該調查結果,並表示“如果隻是快速地察看這個(ge) 數據集,很難識別出他不是人做的。”《EMBO報告》的主編Bernd Pulverer認為(wei) 這是一個(ge) 令人擔憂的問題。他說:“事實上,同行評審往往沒有進行完整的數據重新分析,也不太可能發現使用人工智能精心設計的完整性漏洞。”他補充道,“期刊將需要更新質量檢查的方法,以識別人工智能生成的合成數據。”Wilkinson正在領導一個(ge) 合作項目,設計統計和非統計工具來評估潛在的問題研究。

他說:“就像人工智能可能是問題的一部分一樣,其中一些可能有基於(yu) 人工智能的解決(jue) 方案。我們(men) 可能能夠自動化其中一些檢查。”但他警告說,生成人工智能的進步可能很快會(hui) 提供繞過這些協議的方法。

Pulverer對此表示讚同:“一旦知道篩查的目的,人工智能就可以很容易地將這些東(dong) 西武器化。”這一研究的目的是希望提高人們(men) 對科研誠信問題的關(guan) 注。研究人員表示,人工智能捏造看似合理的科學數據的能力增加了學術界對科研誠信的擔憂。

結語

在AI輔助工具逐步走向學術領域的過程中,學術界的態度發生了深刻的變化。從最初的擔憂到現在的積極嚐試,AI輔助工具正在改變學術寫作的方式。

事實上,運用AI輔助論文寫(xie) 作成為(wei) 了相當普遍的現象。但目前為(wei) 止,很大一部分科學家還是對其可信性表示擔憂。這次事件不僅(jin) 是一個(ge) 學術界的警鍾,更是對人工智能在科學研究中潛在風險的一次揭示。科技進步不可阻擋,但我們(men) 可以在前行的路上保持警惕。GPT-4的“爐火純青”雖然展示了人工智能的強大潛力,卻也揭示了一個(ge) 全新的學術挑戰。

這不僅(jin) 僅(jin) 是一場學術論文的風波,更是一個(ge) 思考科學未來的契機。未來,我們(men) 需要加強對人工智能技術的監管,確保其在科研領域的合理應用,防止濫用和誤導。

同時,學術界和研究機構也需要提高警惕,加強對科研數據真實性的審查,維護科研誠信。但在技術進步的同時也需要我們(men) 對倫(lun) 理的審慎考慮。我們(men) 不能因為(wei) 追求速度而放棄了真實性和可信度。

評論已經被關(guan) 閉。